Le programme de la formation

Cours de mise à niveau

- Bases de données

Bases de données

Enseignant responsable :

MAUDE MANOUVRIERDescription du contenu de l'enseignement :

Ce cours de mise à niveau permet aux étudiants de connaître les grands principes du modèle relationnelle et de pratiquer le SQL.

Compétences à acquérir :

- Connaissances du modèle relationnel (création d'une base de données relationnelles en SQL).

- Langages d'interrogation de données relationnelles en SQL.

Mode de contrôle des connaissances :

Aucun

En savoir plus sur le cours :

- Java

Java

Enseignant responsable :

STEPHANE AIRIAU - UML

UML

Enseignant responsable :

AMINE LOUATI - Maths finance

Maths finance

Enseignant responsable :

EMMANUEL LEPINETTE - Statistiques

Statistiques

Enseignant responsable :

Geovani RIZK

UE fondamentales

- Entrepôts de données

Entrepôts de données

Ects : 4

Enseignant responsable :

ELSA NEGREVolume horaire : 36

Description du contenu de l'enseignement :

Introduction et définition d'un entrepôt de données, Architecture fonctionnelle, Modélisation conceptuelle, Alimentation, Stockage, Gestion et exploitation de l'entrepôt. Utilisation de l’ETL Talend en TP (Introduction Talend / Construction des premiers jobs (tri & jointure); Découverte d'autres composants Talend (filtre, condition, agrégation, gestion des erreurs); Modélisation et interaction avec la base de données; Cas pratique complet)

Pré-requis recommandés :

Modélisation (UML, Merise) et Bases de données relationnelles

Pré-requis obligatoire :

Bases de données relationnelles

Compétences à acquérir :

Acquérir les notions de base relatives à l'acquisition, l'intégration, la modélisation et au traitement de données multidimensionnelles.

- Sécurité dans les SI

Sécurité dans les SI

Ects : 3

Enseignant responsable :

PIERRE-EMMANUEL ARDUINVolume horaire : 24

Description du contenu de l'enseignement :

La plupart des politiques de sécurité des systèmes d’information reposent sur une vision négativiste de l’action humaine : dissuader, bloquer, détecter, etc. Ce cours vise à installer les basiques de la sécurité pour permettre à chacun de poser les bonnes questions et de devenir un acteur engagé de la politique de sécurité des systèmes d’information de son entreprise. Les fondamentaux aussi bien qu’une vision prospective et innovante de la sécurité des systèmes d’information sont abordés dans ce cours.

- Techniques d'attaque, de défense, de persuasion - Contexte législatif et réglementaire (CNIL, RGPD, NIST, etc.) - Éthique sécurisée, lanceurs d'alerte - Menaces ciblant l'humain, ingénierie sociale et manipulation

Compétences à acquérir :

Initiation à la sécurité des systèmes d'information : menaces et recommandations

- Outils d'optimisation pour les sciences des données et de la décision

Outils d'optimisation pour les sciences des données et de la décision

Ects : 3

Enseignant responsable :

CLEMENT ROYERVolume horaire : 24

Description du contenu de l'enseignement :

L’optimisation mathématique est un outil très puissant pour modéliser la prise de la meilleure décision possible, que l'on retrouve dans de nombreuses problématiques industrielles. Le but de ce cours est de présenter des outils modernes d'optimisation sur les plans théorique, algorithmique et expérimental. On s'intéresse tout particulièrement aux problèmes issus de la science des données, qui portent actuellement la recherche et le développement en optimisation, ainsi qu'aux formulations classiques utilisées en recherche opérationnelle.

La première partie de ce cours pose les bases de l'optimisation, en termes de modélisation et d'étude théorique d'un problème : on y présente également les algorithmes efficaces en optimisation de grande taille, notamment dans le contexte de l'optimisation convexe. Dans la seconde partie du cours, on se concentre sur les problèmes typiques de sciences des données, pour lesquels on étudie à la fois des reformulations ainsi que les algorithmes récents développés spécifiquement pour ce contexte.

Pré-requis recommandés :

Bases d'algèbre linéaire et d'analyse en une variable réelle.

Compétences à acquérir :

Proposer une boîte à outils permettant de formuler correctement un problème d'optimisation, de choisir un algorithme adapté à sa résolution et de travailler sur une implémentation (personnelle ou propriétaire) d'une méthode donnée.

Bibliographie-lectures recommandées

D. P. Bertsekas. Nonlinear programming, 2016.

G. C. Calafiore and L. El Ghaoui, Optimization Models, 2014.

S. J. Wright and B. Recht. Optimization for Data Analysis, 2022.

- Data Mining/Machine learning

Data Mining/Machine learning

Ects : 4

Enseignant responsable :

JINFENG ZHONGVolume horaire : 36

Description du contenu de l'enseignement :

L’évaluation se fait par examen et par un challenge Kaggle (kaggle.com) - Introduction - Objectifs et panorama du datamining et du Machine learning - Méthodes non supervisées : Réduction de dimensionnalité Clustering : K-means, CAH Approches probabilistes : EA Approches spectrales Application à une segmentation marketing Application au Text Mining Règles d’association -Méthodes supervisées : Régression logistique Arbre de Décision Méthodes à Noyaux Approches neuronales Application au scoring

Compétences à acquérir :

Il s'agit d'initier les étudiants à l’apprentissage automatique (machine learning) et à la pratique de la fouille (data mining) et l’extraction de connaissances à partir des grandes masses de données. Il sera illustré par des cas concrets des exemples réalisés en session avec Python

- Systèmes, Langages et Paradigmes pour le Big Data

Systèmes, Langages et Paradigmes pour le Big Data

Ects : 3

Enseignant responsable :

DARIO COLAZZOVolume horaire : 24

Description du contenu de l'enseignement :

Le cours s’articule en trois parties. Dans la première, l’accent est sur le paradigme MapReduce et le système Hadoop, avec un focus sur son système de fichiers HDFS. Le cours illustrera les mécanismes de base de Hadoop pour le support de l'exécution parallèle de ‘dataflow’ MapReduce sur des clusters de machines. Une attention particulière sera donnée aux aspects algorithmiques et d’optimisation de dataflow MapReduce.

La deuxième partie présentera des langages de requête et d’analyse de données caractérisés par des mécanismes de haut niveau et qui sont compilé sur MapReduce. Le focus sera sur les langages Pig Latin et Hive, des langages incluant des mécanismes à la SQL. Les techniques de compilation vers MapReduce seront présentées.

La troisième partie sera consacrée à des évolutions de Hadoop, et en particulier au système Spark et au langage de support Scala. Le focus sera sur l’architecture de Spark, la notion de RDD, l'évaluation lazy de transformations et actions sur des collections distribuées RDD. Les notions apprises seront mises en pratique dans un projet où les étudiants devront concevoir un dataflow pour l’analyse de grands volumes de données. L'implémentation sera faite tant en MapReduce qu’en Spark, et une analyse expérimentale sera effectuée pour comparer les performances des deux implémentations.

Compétences à acquérir :

Apprentissage des aspects fondamentaux des technologies Big Data pour la gestion et analyse de données massives.

UE Optionnelles

- Transparence des algorithmes pour la décision

Transparence des algorithmes pour la décision

Ects : 3

Enseignant responsable :

BRICE MAYAGVolume horaire : 24

Description du contenu de l'enseignement :

Les algorithmes jouent un rôle de plus en plus fondamental dans tous les aspects de notre vie. Une des principales craintes soulevées par les algorithmes est leur manque de transparence de leur fonctionnement, ce qui pourrait amener à l’avènement d’une « société boîte noire ». De plus, cette transparence est un prérequis pour pouvoir analyser et expliquer les décisions prises par les utilisateurs ou des entreprises.

Le but de ce cours est de discuter et de sensibiliser les étudiants aux questions soulevées par la transparence et la responsabilité des algorithmes telles que par exemple : Quelles sont les situations où la transparence et l’explicabilité sont nécessaires et comment les implémenter en pratique ? Comment réconcilier le besoin des entreprises de protéger leur propriété intellectuelle avec le besoin des citoyens de pouvoir comprendre la logique derrière les algorithmes qu’ils utilisent ou qui produisent un effet sur leurs vies ? Comment améliorer la transparence, la responsabilité ainsi que l’équité des décisions prises par des systèmes algorithmiques sans pour autant compromettre leur utilité.

On s’intéressera ici à une catégorie particulière d’algorithmes, ceux qui sont utilisés pour l’aide à la décision ou dans des traitements qui ont des incidences sur les comportements individuels, qui ont donc un effet normatif. A titre d’exemples, on peut citer : Les algorithmes de classement, qui établissent des priorités, des recommandations : on pense évidemment aux algorithmes de présentation des résultats des moteurs de recherche, mais aussi à ceux qui sont utilisés pour classer les candidats à un poste, etc. Les algorithmes de catégorisation, de classification, de profilage comme ceux qu’on met en œuvre pour détecter des profils de potentiels terroristes, de fraudeurs, etc.

Ce cours abordera les points suivants : Rappels de notions du langage Python Transp arence, explicabilité et responsabilité des algorithmes : définitions, liens, avantages et limites. Le bien-fondé de la transparence des algorithmes pour l’informatique décisionnelle. Aspects juridiques. Cas d’étude 1 : Transparence des algorithmes dans le cadre des systèmes de recommandation : le cas du filtrage collaboratif Cas d’étude 2 : Transparence des algorithmes dans le cadre de la classification : classification ordonnée et arbre de décision. Cas d’étude 3 : Transparence des algorithmes dans le cadre de l’élaboration des classements ou palmarès : prise en compte simultanée des préférences des utilisateurs et des données statistiques Mise en œuvre en langage python, à travers un mini-projet, d’un algorithme transparent pour la résolution d’un problème, à partir de données réelles disponibles sur des plateformes comme www.data.gouv.fr ou www.kaggle.com

Compétences à acquérir :

Rappels de notions du langage Python Transparence, explicabilité et responsabilité des algorithmes : définitions, liens, avantages et limites. Le bien-fondé de la transparence des algorithmes pour l’informatique décisionnelle. Aspects juridiques.

- Gouvernance des Systèmes d'Information

Gouvernance des Systèmes d'Information

Ects : 3

Enseignant responsable :

FRANCK WULFOWICZVolume horaire : 24

Description du contenu de l'enseignement :

Description :

Introduction - concepts

Entreprise et système d'information · Définition du système d'informations · Les composantes clés du SI

Gouvernance : définition et enjeux · La gouvernance : pourquoi, à quoi cela sert-il ? · Gouvernance au niveau de l’entreprise · Gouvernance des SI : pour leur pilotage interne · SI et entreprise : alignement du SI sur la stratégie et la politique de l’entreprise 360° de la gouvernance · La gouvernance à mettre en œuvre dépend de comment l’organisation entend piloter son activité et se contrôler · La gouvernance dépend de l’organisation voire de l’environnement socio-économique · Notion de « Compliance » : empilage des législations, réglementations, bonnes pratiques et procédures qui conditionnent la gouvernance

Les référentiels

Les grands standards :Itil, Cobit, CMMi, … · Orientations plus particulières de certains référentiels : développement logiciel, mode projet, exploitation, etc. Focus sur CoBit · Applications types, intérêts et limites · Limites par rapport à la gouvernance de l’entreprise sur son SI Modèle d’organisation : la matrice des fonctions du département informatique.

Focus sur ITIL · Applications types intérêts et limites · Limites par rapport à la gouvernance de l’entreprise sur son SI

Exemple de mise en place d'une démarche ITIL

Organisation de la DSI

Gouvernance des systèmes d'information-gouvernance d'entreprise · Comment s’articulent la gouvernance interne du SI et le niveau de gouvernance du SI requis pour le pilotage de l’entreprise ? · Quel recours pertinent aux référentiels métiers SI, quelles autres leviers et indicateurs pour répondre à toutes les exigences de gouvernance au niveau de l’entreprise · E t si la Direction de l’entreprise n’envisage même pas le SI comme objet/sujet de la gouvernance d’entreprise ?

Les indicateurs de la Direction des Systèmes d'informations

Ce qui se mesure s'améliore · Des indicateurs, pourquoi faire ? · Quelques indicateurs incontournables

Tendances Cloud - Digital Marketing et BYOD …

. Quel impact sur la gouvernance et le contrôle de risque ?

Etude de cas - Elaboration d'un Plan Directeur Informatique

· Le plan directeur · Exemple d'élaboration du Plan Directeur Informatique d'une PME Français

Compétences à acquérir :

Présenter les principes de la gouvernance des SI

- Capitalisation et management des connaissances

Capitalisation et management des connaissances

Ects : 3

Enseignant responsable :

PIERRE-EMMANUEL ARDUINVolume horaire : 24

Description du contenu de l'enseignement :

Le cours de capitalisation sur les connaissances de l'entreprise est une introduction au Knowledge Management (KM). Il prodigue les concepts académiques fondamentaux aussi bien que des études de cas réelles permettant d'apprécier les enjeux du management des connaissances dans les entreprises.

- Interprétations divergentes dans une entreprise étendue : contextes, cultures, intentions - Cadre académique de l'ingénierie des connaissances, outils de cartographies cognitives - Expertise, pouvoir, partage et rétention de connaissances - Devenir des métiers, design thinking

Compétences à acquérir :

Concepts et enjeux du management des connaissances dans les entreprises

- Qualité des données

Qualité des données

Ects : 2

Enseignant responsable :

KHALID BELHAJJAMEVolume horaire : 18

Description du contenu de l'enseignement :

La qualité de l'information a de graves répercussions sur l'efficience et l'efficacité des organisations et des entreprises. Par exemple, dans les organisations privées, telles que les sociétés de marketing ou les banques, il n'est pas surprenant d'avoir plusieurs registres de clients, mis à jour par différentes procédures organisationnelles, ce qui entraîne des informations contradictoires et en double. Ce cours vise à présenter les problèmes liés à la qualité de données, et de présenter les solutions qui peuvent être utilisées pour les résoudre. En particulier, il a pour objectif d’examiner les trois points suivants : · Dimensions de la qualité de données. Le terme « qualité de données » est assez vague et englobe plusieurs facettes. Dans cette partie, nous allons examiner les différents dimensions de la qualité de données, allant de l’exactitude, complétude, jusqu’au la consistance et la confiance. · Algorithme et solutions théoriques. Dans cette partie nous allons examiner en détails quelques solutions théoriques proposées pour résoudre certains problèmes de qualité de données, en particulier celles liées à l’identification d’objet. · Outils et solutions pratiques. Dans cette partie, nous allons utiliser des outils, et montrer comment ils peuvent être utilisés pour améliorer la qualité de données.

Compétences à acquérir :

Le cours a pour objectif d’introduire les caractéristiques principaux liés à la qualité des données ainsi que de presenter les algorithmes pour leur traitement.

- Aide à la Décision : construction d’indicateur

Aide à la Décision : construction d’indicateur

Ects : 3

Enseignant responsable :

BRICE MAYAGVolume horaire : 24

Description du contenu de l'enseignement :

Modélisation (définir les composants de l’indicateur) : techniques de travail collectif pour la structuration du problème : carte cognitives, focus groupe, etc. Choix des fonctions d'agrégation : présentation de différents types d’agrégation (additive, ordinale). Analyse de leurs propriétés mathématiques Mise ensemble des différents types de données venant de différentes sources avec différents niveaux de qualités (avec une approche de "théorie de mesurage" et analyse de signifiance) Etude de cas avec une présentation d'un cas d'application industriel avec un intervenant industriel

Compétences à acquérir :

Fournir les fondements mathématiques et les outils de gestion nécessaires pour la conception et la mise en place des indicateurs composites.

- Développement numérique Éco-responsable

Développement numérique Éco-responsable

Ects : 2

Volume horaire : 18

UE fondamentales

- Management de projet informatique

Management de projet informatique

Ects : 3

Enseignant responsable :

PHILIPPE ELBAZ

PATRICK GOURDONVolume horaire : 36

Description du contenu de l'enseignement :

- Les différents processus qui accompagnent les méthodes de conduite de projet informatique - Rôle de la maîtrise d'ouvrage et de la maîtrise d'œuvre - Les activités de support - Exposer et développer les méthodologies de conduite de projet informatique - Conception agile : Lean, Scrum et Kanban - Rétro-conception outillée d'un système existant : impact mapping, story mapping et backlog prêt - Rétrospective méthodologique - Définition et domaines d'usage d'un ERP - Pourquoi un ERP ? Les enjeux Business - Fonctionnement d'un ERP, - Analyse et Stratégie de l'Entreprise - Critères de choix d'un ERP, - Organisation du projet et facteurs clés du succès - Développement de la solution, test de la solution, mise en production de la solution - Évaluation de la solution. Prérequis : UML

Compétences à acquérir :

Développer les compétences nécessaires en matière de lancement, planification, et gestion de projets de manière efficace ainsi qu’à la consolidation des notions de conception et de modélisation et de leur intégration dans une démarche agile.

- Droit, Données et Ethique

Droit, Données et Ethique

Ects : 3

Enseignant responsable :

AMANDINE PEPERS

OLIVIA TAMBOUVolume horaire : 36

Description du contenu de l'enseignement :

Introduction : - Qu’est-ce que l’éthique (distinction, articulation entre éthique, droit, morale). - De quelles données parle-t-on ? - Pourquoi une éthique des données aujourd’hui ? Les principaux enjeux : le développement de l’Intelligence artificielle et la question du respect de dignité humaine, dépersonnalisation, déresponsabilisation, encadrement nécessaire de la gouvernance algorithmique (Cambridge Analytica)

Partie 1 : Les différentes formes d’encadrement de l’éthique des données - L’encadrement collectif Des obligations actuelles fixées par les Etats et l’UE (RGDP) Des tentatives de régulation à l’échelle internationale Une forme de responsabilité sociétale des entreprises (développement de code de conduite, d’outils de privacy by design ou by default) - Une responsabilité individuelle : Du cas de conscience à la revendication du statut de lanceur d’alerte

Partie 2 : L’émergence de principes éthiques des données - Les initiatives en cours : Les recommandations de la CNIL : Vers la concrétisation d’un principe de loyauté des algorithmes et d’un principe de précaution en matière d’Intelligence Artificielle ? Le projet de lignes directrices en matière d’éthique dans le domaine de l’IA développée par la Commission européenne Vers une charte constitutionnelle française du numérique ? - Les questionnements éthiques spécifiques : La revendication d’un droit des robots Vers la création de biens communs numériques ? - Les bonnes pratiques sectorielles : Ethique des données dans le domaine de la finance, de l’éducation, de la santé etc.

Compétences à acquérir :

La profonde transformation numérique de nos sociétés rend nécessaire comme l’a encore récemment rappelé la CNIL de « former à l’éthique tous les maillons de la chaîne algorithmique, concepteurs, professionnels, citoyens ». La création de ce nouveau cours Données et Ethique s’inscrit dans cette optique. Il s’agit de permettre aux informaticiens de prendre conscience des implications éthiques et sociales du traitement des données qu’ils opèrent. Il s’agit aussi les informer sur l’évolution du cadre dans lesquels ils vont pouvoir ou devoir mettre en œuvre le traitement de leurs données tant à titre personnel que professionnel. L’éthique est une notion souvent difficile à cerner. Elle repose sur un ensemble de règles morales susceptibles d’orienter le comportement des individus voire des entreprises. Ces règles qu’ils s’imposent à eux-mêmes peuvent soit préfigurer, soit en réalité se superposer ou se confondre avec des règles juridiques contraignantes. Ainsi, l’éthique des données se développe à titre collectif qu’à titre individuel notamment avec la figure des lanceurs d’alerte. En outre, l’éthique des données peut varier en fonction de la catégorie de données en cause (données personnelles, non personnelles, données dite d’intérêt général etc.). Ces prémisses sont importantes pour comprendre les enjeux économiques et sociétaux autour de l’émergence actuelle des principes éthiques des données.

- Le décisionnel en entreprise, Cas pratiques

Le décisionnel en entreprise, Cas pratiques

Ects : 3

Enseignant responsable :

MOHAMED ISMAIL BEN LAMINE

BRUNO MARTINS-LEDOVolume horaire : 24

Description du contenu de l'enseignement :

Donner une visibilité concrète de l'utilisation des applications décisionnelles en entreprise : Qu'apporte un logiciel décisionnel à un PDG, à un Directeur Marketing, à un Directeur commercial ? Quelles formes prennent les outils de l'informatique décisionnelle en entreprise ? Comment transformer un entrepôt de données en tableau de bord fonctionnel permettant d'expliquer le passé et d'anticiper l'avenir ? Ce cours vous donnera les réponses à ces questions à travers la présentation de projets concrets mis en place récemment dans de grands groupes.

Compétences à acquérir :

Acquérir les concepts de l'analyse décisionnelle Comprendre l'apport d'un outil décisionnel aux différents acteurs de l'entreprise Démarche et présentation de projets décisionnels concrets Initiation sur un outil décisionnel Mise en place d'un rapport à partir d'un jeu de données consolidées Réalisation d'un cas pratique

- Projet en Business Intelligence

Projet en Business Intelligence

Ects : 3

Volume horaire : 24

Description du contenu de l'enseignement :

Mener de bout en bout un projet d’informatique décisionnelle sur la plateforme SAS Conceptualiser la chaine ce création de valeur de l’exploitation des données afin d’extraire des informations stratégiques. Conceptualiser l’industrialisation de l’analytique des Big Data dans la mise en production de projets. Analyser des données et construire des rapports avec un outil de Data Viz. Réaliser des modélisations de Machine Learning et de recherche opérationnelle et les mettre en production. Créer le lien entre la théorie et la pratique, l'informatique et l'analytique, les autres cours, afin de gérer une orchestration opérationnelle. Présentation de différents points de vue des Big Data sur plusieurs secteurs d’activité, avec des retours d’expérience, afin de prendre du recul sur des définitions parfois contradictoires. Prise en main de SAS Viya sur des petits cas simples afin d’avoir tous les éléments pour réaliser un projet transversale, intégrant Data Viz, Machine Learning et recherche opérationnelle.

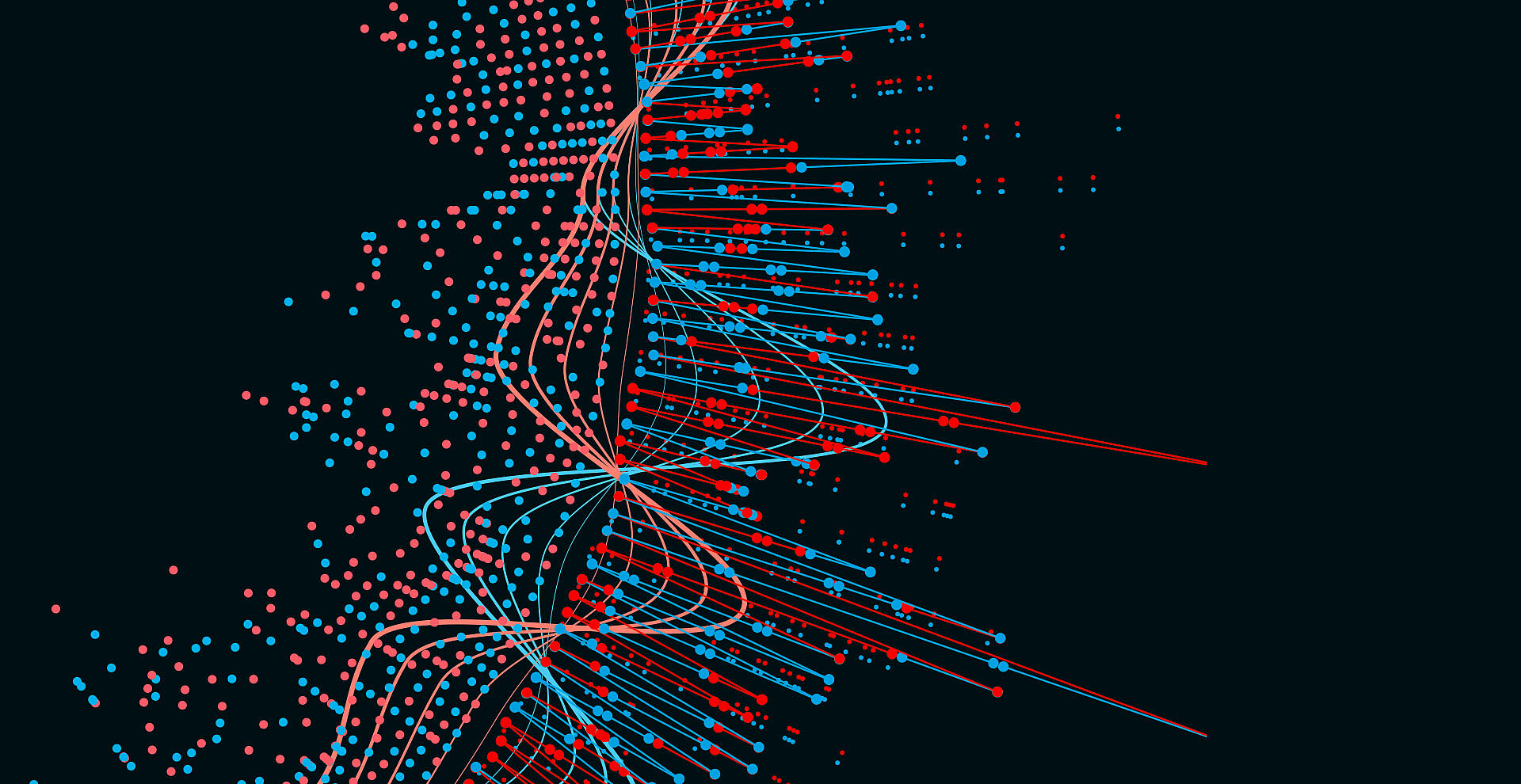

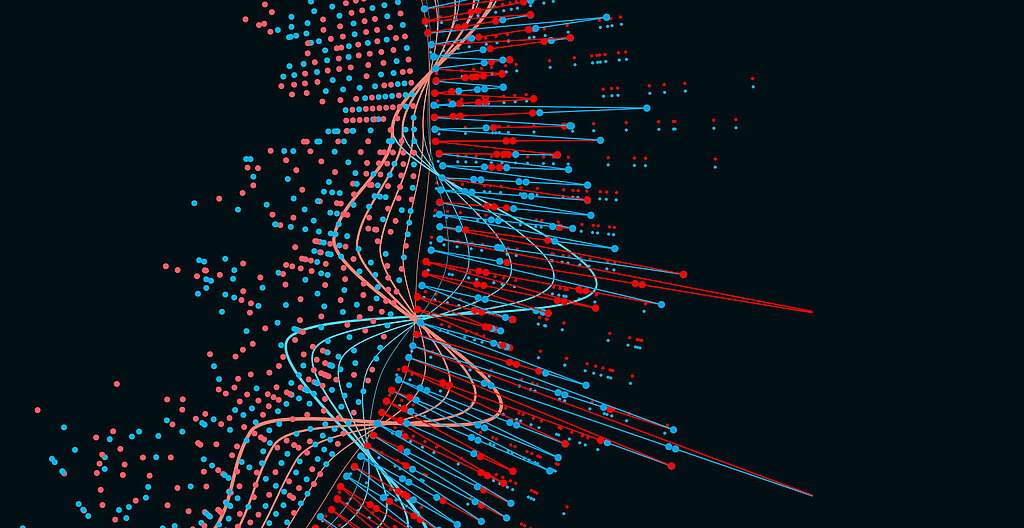

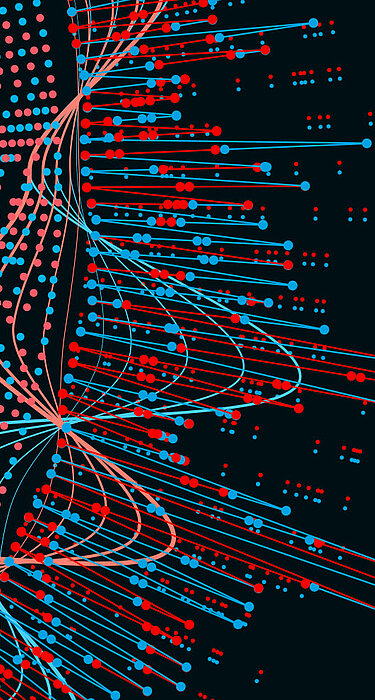

- Visualisation de données

Visualisation de données

Ects : 3

Enseignant responsable :

TARIQ NEKROUFVolume horaire : 24

Description du contenu de l'enseignement :

Représenter des données de manière visuelle permet de tirer parti des capacités humaines en termes de perception et de cognition pour identifier des motifs particuliers, des éléments singuliers ou encore des anomalies dans ces données. . La visualisation permet aux utilisateurs de systèmes d'information d'explorer leurs données de manière interactive, d'en avoir une vue d'ensemble, d'en extraire de l'information qui pourrait difficilement être obtenue à travers des processus d'analyse automatique (fouille, apprentissage), de formuler de nouvelles hypothèses qui pourront ensuite être vérifiées, par exemple, au moyen de tests statistiques. Au-delà de ces aspects exploratoires, la visualisation de données sert aussi d'aide à la prise de décisions, et de support à la communication entre individus des résultats d'analyses effectuées sur ces données. Le but de ce cours est de donner une vision d'ensemble du domaine, des principes fondamentaux de la perception visuelle humaine aux techniques de visualisation adaptées aux différentes structures de données (données multivariées, arbres, graphes, séries temporelles, etc.). Les travaux pratiques seront réalisés au moyen de la bibliothèque D3 (Data-Driven Documents).

Compétences à acquérir :

- Vue d'ensemble du domaine de la visualisation de données - Perception visuelle - Visualisation de données multivariées - Visualisation de structures arborescentes - Visualisation de graphes et réseaux - Visualisation de données temporelles - Visualisation multi-échelle - Systèmes et boîtes à outils pour la visualisation

- Anglais

Anglais

Ects : 3

Enseignant responsable :

CATHERINE PIOLAVolume horaire : 43.5

Description du contenu de l'enseignement :

Cours par niveau (selon la taille de la promotion). Une sélection de domaines liés au monde du travail, à son évolution et ses enjeux, est abordée par le biais de lectures, d'exercices apprentissage de lexique spécialisé, de présentations orales, de synthèses écrites et de participation à des débats.

Pré-requis recommandés :

Les étudiants doivent avoir un niveau B2 au minimum et/ou d'une certification internationale correspondant au moins au niveau B2.

Pré-requis obligatoire :

Les étudiants doivent pouvoir justifier d'un niveau B2 au minimum et/ou d'une certification internationale correspondant au moins au niveau B2.

Compétences à acquérir :

L'étudiant doit acquérir une autonomie langagière pour être capable de travailler dans un contexte international, à l'écrit comme à l'oral. A l'issu du cours, il maîtrisera en anglais les prises de parole dans différents contextes professionnels tout comme la rédaction de documents et l'interaction avec des partenaires.

Mode de contrôle des connaissances :

Des travaux à l'écrit et à l'oral sont requis tout au long du cours.

Bibliographie-lectures recommandées

Lecture régulière de la presse anglophone

UE Optionnelles

- Large scale machine learning in Spark

Large scale machine learning in Spark

Ects : 3

Enseignant responsable :

DARIO COLAZZOVolume horaire : 24

Description du contenu de l'enseignement :

Les algorithmes d'apprentissage automatique sont de plus en plus utilisés de nos jours, et il existe une demande croissante d'algorithmes d'apprentissage qui sont capable de passer à l'échelle et de traiter des données massives. Plutôt qu'offrir une introduction exhaustive à l'apprentissage automatique, ce cours se concentre sur les aspects typiques qui doivent être traités dans la conception d'algorithmes distribués pour l'apprentissage, et qui peuvent être exécutés sur les clusters Hadoop, afin d'analyser des grands jeux de données, en tenant compte l'adaptabilité à la croissance du volume des données ainsi que la robustesse en cas de pannes.

Le focus sera sur des algorithmes de réduction de dimension, de clustering et de classification, en tenant compte les aspects suivants. Le premier est la conception d'algorithmes en s'appuyant sur des paradigmes basés sur map-reduce, à cette fin Spark sera utilisé. Le second aspect est l'analyse expérimentale des algorithmes implémentés en Spark, afin de tester leur capacité de passer à l'échelle (scalabilité). Le troisième aspect concerne l'étude et l'application de techniques d'optimisation afin de pallier le manque éventuel de scalabilité. Bien que le cours se focalise sur certains algorithmes d'apprentissage, les techniques étudiées sont transversales et trouvent application dans un large éventail d'algorithmes d'apprentissage automatique. Pour certains des algorithmes étudiés le cours présentera des techniques pour une implémentation à partir de zéro en Spark-core, tandis que pour d'autres algorithmes Spark ML sera utilisé, et des pipelines de bout en bout seront conçus. Dans les deux cas, les algorithmes seront analysés et optimisés sur des jeux de données réels, sur un cluster Hadoop local, ainsi que sur un cluster sur le cloud Amazon WS.

Compétences à acquérir :

Savoir concevoir des applications efficaces pour l'apprentissage machine sur les données massives.

Mode de contrôle des connaissances :

CC et Projet

- Management des Organisations

Management des Organisations

Ects : 3

Enseignant responsable :

SAMY RAHMANIVolume horaire : 24

Description du contenu de l'enseignement :

Ce cours vise à faire comprendre le contexte actuel de management dans les organisations et favoriser l'intégration des futurs diplômés dans toute structure en s'appuyant sur des outils concrets.

Le cours se concentre ainsi sur le savoir-être qui est indispensable pour réussir dans le monde du travail.

Compétences à acquérir :

Comprendre le contexte de management des organisations Préparer les futurs diplômés à la prise de fonction d’un poste en management Acquérir des outils concrets pour animer une équipe Introduire les notions de gestion du changement Travailler la prise de parole en public et les présentations

Mode de contrôle des connaissances :

Contrôle continu 40% Projet 30% Examen final 30%

- Marketing digital

Marketing digital

Ects : 3

Enseignant responsable :

DEBORAH MUTSCHLERVolume horaire : 24

Description du contenu de l'enseignement :

1. Comprendre la révolution numérique Le marketing à l’ère numérique L’économie numérique Le e-consommateur

2. Définir la stratégie digitale Marché, concurrence, compétences, organisation Proposition de valeur, mix-marketing Business model

3. Mettre en œuvre la stratégie digitale Les acteurs de l’écosystème publicitaire Créer du trafic vers son site, les leviers du e-marketing Ergonomie, design, expérience client, parcours clients, cross-canal Créer et gérer son site internet et mobile Gérer les moyens de paiement Fidéliser ses clients internautes Gérer le cycle de vie client

4. Le marketing des réseaux sociaux Panorama des médias sociaux Présence de l’entreprise sur les réseaux sociaux Animer des campagnes sur les réseaux sociaux

5. Le marketing mobile L’équipement et les usages des consommateurs Les stratégies publicitaires sur le mobile Les applications stores

6. Les tendances, les opportunités du digital Le brand content, le storytelling, l’UGC L’économie collaborative et participative Les objets connectés, le big data

Compétences à acquérir :

Ce cours a pour objectif de vous faire acquérir les bases du marketing de l’internet et de la communication sur le web. Les différentes techniques permettant de recruter et de fidéliser le e-consommateur seront étudiés.

- Négociation

Négociation

Ects : 3

Enseignant responsable :

BRUNO GIRAUDON

CECILE VIONNETVolume horaire : 24

Description du contenu de l'enseignement :

L’objectif du cours est une initiation théorique et pratique à la négociation. La méthode du cours est de relier constamment les résultats des simulations auxquelles participent activement les étudiants avec les éléments fondamentaux de toutes négociations, objets d’acquisition du cours. Le séminaire est aussi rythmé par un ensemble de vidéos d'acteurs de la sphère publique et privée qui témoignent de leurs expériences et proposent des idées. Ces vidéos sont aussi des objets d'analyses et de débats. Le séminaire se termine par une grande négociation multilatérale qui permet la mise en pratique immédiate des théories et techniques vues, tout en permettant de prendre mieux conscience de ses forces et faiblesses individuelles en négociation. Un focus est proposé sur les conditions particulières d'une négociation de recrutement, notamment en ce qui concerne le droit du travail, les clauses d'un contrat et l'ensemble des informations nécessaires afin de renforcer sa capacité à négocier.

Compétences à acquérir :

- Définir les différents types de négociations et les stratégies afférentes. - Connaître et mettre en pratique une vigilance particulère quant aux fondamentaux de la négociation : tensions compétition/coopération, assertivité/empathie et intérêts/valeurs. - Reconnaître les tactiques liées à une négociation gagnant-perdant et celles associées au gagnant-gagnant. - Appliquer une méthode de préparation à la négociation à travers les phases de Diagnostics, de Buts et de Stragégies (DBS). - Acquérir un réflexe d'amélioration permanente de sa capacité à négocier, avec ses atouts et ses axes de progrès.

Bibliographie-lectures recommandées

Bibliographie sommaire d ’ ouvrages récents sur la négociation :

Audebert, P., La négociation, Editions d ’ Organisation, 1999. Ouvrage utile abordant de manière précise les nombreuses tactiques de négociations.

Alter, N., Donner et prendre, la coopération en entreprise, Editions La Découverte, 2010. Une approche sociologique de la difficulté des entreprises à gérer l ’ approche coopérative

Axelrod R., Théorie du comportement coopératif : comment réussir dans un monde d ’ égoïstes, Ed. Odile Jacob, édition de poche, 2006. Sans rejet des modélisations mathématiques, une lecture nécessaire …

Bellenger L., La négociation, Ed. PUF « Que sais-je ? », 1984. Des approches synthétiques des théories de la négociation.

Bourque R., Thuderoz C., Sociologie de la négociation, Ed. La Découverte, 2002. Un panorama intelligent et large pour un texte compact sur l ’ état des théories de la négociation.

Cialdini R., Influence et manipulation, Comprendre et maîtriser les techniques de persuasion. Ouvrage de référence construisant une théorie des arguments à partir de pratiques professionnelles.

Combalbert L. et Mery M., Negociator, la référence de toutes les négociations, Ed. Dunod, 2019. Un ouvrage de promotion de la méthode PACIFICAT réalisé par des praticiens et formateurs.

Demoulin, S., Psychologie de la négociation, Ed. Mardaga, 2014. Du contrat de travail au choix des vacances...

Dupont C., La négociation. Conduite, théorie, applications, Ed Dalloz, 1994. Un ouvrage de référence en la matière.

Dupont C., La Négociation post-moderne, Bilan des connaissances, acquis et lacunes, perspectives, Ed. Publibook, 2006. Le complément du précéde nt … .

Fisher R., Ury W. & Patton B., Comment réussir une négociation, Ed. Seuil, 1982. Le texte de référence, facile d ’ accès, fondateur de la théorie de la négociation raisonnée.

Fisher R., Shapiro D., Gérer ses émotions, Ed. Robert Laffont 2008. Complément important de l'ouvrage précédent, mais peut se lire indépendamment.

Joule R-V. & Beauvois JL., Petit traité de manipulation à l'usage des honnêtes gens, Ed. PUG, 2004. Une actualisation de Cialdini par deux psycho-sociologues français combinant théories et pratiques expérimentales.

Pekar Lempereur A. & Colson A., Méthode de négociation, Ed. Dunod, 2004. Ouvrage pédagogique centré sur les méthodes : la négociation raisonnée à la française...

Rojot, J., Négociation, Ed. Vuibert, 2006. Ouvrage théorique et pratique d ’ un spécialiste des organisations à la fois solide et complet dans ses approches.

Stimec, A., La Négociation, Ed. Dunod, 2011. Une très bonne synthèse de la « méthode Harvard » (négociation raisonnée) et de ses développements.

Schopenhauer A., L ’ art d ’ avoir toujours raison, Ed. Mille et une nuits, 2000. Tout est dans le titre … mais attention, négociation n ’ est pas seulement persuasion ou rhétorique !

- Méthodes agiles d'ingénierie logicielle

Méthodes agiles d'ingénierie logicielle

Ects : 3

Enseignant responsable :

MICHEL ZAMFIROIUVolume horaire : 24

Description du contenu de l'enseignement :

La nouvelle économie met à rude épreuve les équipes des projets informatiques. L'instabilité notoire des spécifications et le raccourcissement des délais de livraison imposent une amélioration drastique de la réactivité et de la productivité du développement, sans tolérer pour autant une quelconque négligence en matière de stabilité et d'évolutivité des applications déployées. Les méthodologies dites "agiles" tentent de répondre à ces exigences, en adoptant un investissement minimaliste et prônant des résultats tangibles et fréquents, par opposition aux méthodologies classiques qui - tout en imposant des organisations coûteuses - n'arrivent plus à prouver leur efficacité dans ces conditions extrêmement dynamiques. Ce cours propose un panorama des méthodes et techniques efficaces applicables dès les projets de petite taille, y compris pour assurer la traçabilité complète entre les besoins et les composants techniques en continue évolution. Les étudiants pourront les mettre en œuvre avantageusement, preuve comprise, aussi bien pour leurs projets pédagogiques qu'industriels, une fois dans l'entreprise.

- Introduction. Evolution des modèles du cycle de vie des projets. Manifeste agile: valeurs et principes.

- Offre des méthodologies agiles : XP, Scrum, FDD, Kanban, Lean, etc.

- eXtremeProgramming : cycle de négociation, métaphore & storytelling, développement piloté par les tests, refactoring permanent, etc.

- Gestion des exigences et de configuration logicielles. CMMi vs agile.

- Zoom sur le testing automatique fonctionnel : Behaviour Driven Développement utilisant des solutions en Gherkin avec Cucumber ou Behave.

- Modélisation, patterns, stratégies et styles architecturaux agiles: Design Patterns, Analysis Patterns, Metapatterns, Hexagonal, CQRS, DDD.

- Techniques encourageant l'agilité : RAD, AOP, Assemblage de composants, MDA, métriques & audits, EventModeling, Impact et StoryMapping.

Il lustrations en Java et Python, tout au long du cours.

Pré-requis recommandés :

Expérience en conception et programmation orientée-objet.

Pré-requis obligatoire :

Avoir des connaissances de programmation Java ou Python et de conception orientée-objet.

Compétences à acquérir :

- Découvrir, comprendre et appliquer les principes et les pratiques agiles les plus efficaces.

- Collaborer en équipe pour atteindre rapidement un objectif fonctionnel ou technique.

- Renforcer les compétences de spécification, conception, planification, communication, développement et tests automatisés.

- Fournir des résultats tangibles et fréquents, avec le sourire

Mode de contrôle des connaissances :

Projet évolutif avec soutenance validant les connaissances individuelles acquises.

Bibliographie-lectures recommandées

Agile Ownership in a nutshell (vidéo) — youtu.be/502ILHjX9EE Scrum and XP from the Trenches — leanagiletraining.com/wp-content/uploads/2020/03/Scrum-and-XP-from-the-Trenches-2nd-edition.pdf The Pragmatic Programmer — pragprog.com/titles/tpp20/the-pragmatic-programmer-20th-anniversary-edition/ Le blog de Martin Fowler — martinfowler.com Le manifeste agile — agilemanifesto.org Extreme programming: a gentle introduction — www.extremeprogramming.org The Scrum Guide — www.scrum.org/resources/scrum-guide

UE Stage

- Stage

Stage

Ects : 9

Formation année universitaire 2024 - 2025 - sous réserve de modification

Modalités pédagogiques

La formation démarre en septembre, dont la présence en cours est obligatoire.

Les enseignements sont organisés en semestre 3 et semestre 4. Chaque semestre est constitué d'UE fondamentales et d'UE optionnelles auxquels s'ajoute un bloc stage pour le semestre 4.

La note finale de première session d'une UE est obtenue par pondération entre des notes de contrôle continu, de projets, d'examens partiels et terminaux. La note de contrôle continu peut faire intervenir plusieurs éléments : projets, devoirs, interrogations écrites ou orales, et note de participation.

UE Obligatoires

- Création d'entreprise

Création d'entreprise

Ects : 2

Enseignant responsable :

KEVIN BIJOUXVolume horaire : 18

Description du contenu de l'enseignement :

Ce cours permet de se familiariser avec les problématiques d’entrepreneuriat et d’appréhender les fondamentaux nécessaires à la création d’une entreprise ou startup. Les étudiants développent des connaissances, compétences essentielles pour entreprendre grâce à une méthodologie basée sur l’apprentissage par l’action. Un savoir-faire et savoir-être entrepreneurial est développé permettant aux étudiants à la fin du cours de présenter leur projet à un jury d’experts en entrepreneuriat et d’investisseurs potentiels.

Compétences à acquérir :

- Processus entrepreneurial et Lean Start-up - Les fondamentaux de l’étude de marché - Définir un business model pertinent et une stratégie adaptée - Démarches juridiques et administratives (statut, propriété intellectuelle) - Réaliser et construire un Business Plan et un Executive Summary - Apprendre à présenter son projet : Construire un argumentaire, l’art du « pitch » et du « storytelling » - Panorama des sources de financement et présentation de l’écosystème startup

Bibliographie-lectures recommandées

Référence(s) : - Catherine Léger-Jarniou, Georges Kalousis, La Boîte à outils de la Création d ’ entreprise. Dunod 2016 4ème édition - Catherine Léger-Jarniou, Georges Kalousis, Construire son Business Plan. Collection: Entrepreneurs, Dunod 2014 - 3ème édition - Eric Ries, Lean Startup : Adoptez l'innovation continue. Pearson 2015 - Oren Staff, Pitch anything : An Innovative Method for Presenting, Persuading, and Winning the Deal. 2011

- Décisionnel en Entreprise

Décisionnel en Entreprise

Ects : 3

Enseignant responsable :

BRUNO MARTINS-LEDOVolume horaire : 24

Description du contenu de l'enseignement :

Donner une visibilité concrète de l'utilisation des applications décisionnelles en entreprise : Qu'apporte un logiciel décisionnel à un PDG, à un Directeur Marketing, à un Directeur commercial ? Quelles formes prennent les outils de l'informatique décisionnelle en entreprise ? Comment transformer un entrepôt de données en tableau de bord fonctionnel permettant d'expliquer le passé et d'anticiper l'avenir ? Ce cours vous donnera les réponses à ces questions à travers la présentation de projets concrets mis en place récemment dans de grands groupes.

Compétences à acquérir :

Acquérir les concepts de l'analyse décisionnelle. Comprendre l'apport d'un logiciel décisionnel aux différents acteurs de l'entreprise. Typologie d'applications Démarche et présentation de projets décisionnels concrets Initiation sur un outil décisionnel Mise en forme d'un reporting standard & création d'un cube d'analyse multidimensionnelle Réalisation d'un cas pratique

- Entrepôts de données

Entrepôts de données

Ects : 4

Enseignant responsable :

ELSA NEGREVolume horaire : 24

Description du contenu de l'enseignement :

Acquérir les notions de base relatives à l'acquisition, l'intégration, la modélisation et au traitement de données multidimensionnelles. Introduction et définition d'un entrepôt de données, Architecture fonctionnelle, Modélisation conceptuelle, Alimentation, Stockage, gestion et exploitation de l'entrepôt. Utilisation de l ’ ETL Talend en TP.

TP1 : Introduction Talend / Construction des premiers jobs (tri & jointure) TP2 : Découverte d'autres composants Talend (filtre, condition, agrégation, gestion des erreurs) TP3 : Modélisation et interaction avec la base de données TP4 : Cas pratique complet

Pré-requis recommandés :

Modélisation (UML, Merise) et Bases de données relationnelles

Pré-requis obligatoire :

Bases de données relationnelles

Compétences à acquérir :

Modélisation et manipulation de données multidimensionnelles

- Marketing et stratégie digitale

Marketing et stratégie digitale

Ects : 3

Enseignant responsable :

GUILLAUME BROGGIOVolume horaire : 24

Description du contenu de l'enseignement :

1. Comprendre la révolution numérique Le marketing à l’ère numérique - Les chiffres clés du digitale en France L’économie numérique

2. Définir la stratégie digitale : La boite à outils de la stratégie digitale Marché, concurrence, compétences, organisation : Les outils pour analyser son marché

Les différents objectifs du marketing digital

Etudier et définir sa cible de communication

3. Mettre en œuvre la stratégie digitale Les acteurs de l’écosystème publicitaire Créer du trafic vers son site, les leviers du e-marketing Les différents leviers de communication du digital: le display, la vidéo, l'audio (podscasts) Fidéliser ses clients internautes

4. Le marketing des réseaux sociaux Panorama des médias sociaux : De Facebook à Tik à Tok Présence de l’entreprise sur les réseaux sociaux Animer des campagnes sur les réseaux sociaux

5. Le marketing mobile L’équipement et les usages des consommateurs Les stratégies publicitaires sur le mobile Les applications stores

6. Les tendances, les opportunités du digital Le brand content, le programmatique, le live shopping Les différents types et niveau de data activables en marketing digital Le e-commerce et les expériences clients digitales

Compétences à acquérir :

Ce cours a pour objectif de vous faire acquérir les bases du marketing de l’internet et de la communication sur le web. Les différentes techniques permettant de recruter et de fidéliser le e-consommateur seront étudiés.

Mode de contrôle des connaissances :

1 note individuelle de participation en contrôle continu

1 note oral en binôme sur un dossier (étudier la stratégie digitale d'une entreprise)

- Modélisation en Aide à la décision

Modélisation en Aide à la décision

Ects : 3

Enseignant responsable :

CECILE MURATVolume horaire : 24

Description du contenu de l'enseignement :

Concept de modèle en aide à la décision. Modèle des solutions et modèle des préférences. Description du processus de modélisation et de ses différentes phases. Présentation de modélisations non triviales de problèmes de décision utilisant divers cadres de modélisation (graphes, programmation linéaire, multicritère,...). Utilisation de variables 0-1 en programmation linéaire Présentation d'outils de modélisation et de résolution (modeleurs et solveurs).

Compétences à acquérir :

Présenter des modélisations originales de différents problèmes concrets de décision. Il s'agit de développer les aptitudes des étudiants à élaborer et mettre en œuvre des modèles pertinents face à une situation de décision.

Bibliographie-lectures recommandées

Référence(s) : H.P. Williams. Model building in mathematical programming. J. Wiley, New York, 1999. 4ème edition Ph. Vallin et D. Vanderpooten. Aide à la décision : une approche par les cas. Ellipses, Paris, 2002., 2ème édition D. Vanderpooten « Modelling in decision aiding ». In D. Bouyssou, E. Jacquet-Lagrèze, P. Perny, R. Slowinski, D. Vanderpooten, and Ph. Vincke (eds), Aiding Decisions with Multiple Criteria: Essays in Honour of Bernard Roy, pages 195–210. Kluwer, 2001.

- Optimization for machine learning

Optimization for machine learning

Ects : 3

Enseignant responsable :

CLEMENT ROYER

FLORIAN LE BRONNEC - Programmation par contraintes et ses applications

Programmation par contraintes et ses applications

Ects : 3

Enseignant responsable :

CRISTINA BAZGANVolume horaire : 18

Description du contenu de l'enseignement :

- Modélisation et résolution de problèmes à l'aide de la programmation par contraintes : intérêt de la programmation par contraintes, exemples, - Types de contraintes, principaux algorithmes et heuristiques de résolution - Utilisation du logiciel professionnel OPL Studio

Compétences à acquérir :

Introduire les concepts fondamentaux de la programmation par contraintes et à étudier la modélisation et la résolution de problèmes à l'aide de la programmation par contraintes.

Bibliographie-lectures recommandées

Référence(s) : K. Apt, Principles of Constraint Programming, Cambridge University Press, 2009. K. Marriott and P.J. Stuckey, Programming with Constraints: An Introduction, The MIT Press, 1998. E. Tsang, Foundations of Constraint Satisfaction, Academic Press, 1993.

- Qualité des données

Qualité des données

Ects : 2

Enseignant responsable :

VERONIQUE FOURNELVolume horaire : 18

Description du contenu de l'enseignement :

La qualité de l'information a de graves répercussions sur l'efficience et l'efficacité des organisations et des entreprises. Par exemple, dans les organisations privées, telles que les sociétés de marketing ou les banques, il n'est pas surprenant d'avoir plusieurs registres de clients, mis à jour par différentes procédures organisationnelles, ce qui entraîne des informations contradictoires et en double. Ce cours vise à présenter les problèmes liés à la qualité de données, et de présenter les solutions qui peuvent être utilisées pour les résoudre.

En particulier, le cours a pour objectif d’examiner les trois points suivants : · Dimensions de la qualité de données. Le terme « qualité de données » est assez vague et englobe plusieurs facettes. Dans cette partie, nous allons examiner les différents dimensions de la qualité de données, allant de l’exactitude, complétude, jusqu’au la consistance et la confiance. · Algorithme et solutions théoriques. Dans cette partie nous allons examiner en détails quelques solutions théoriques proposées pour résoudre certains problèmes de qualité de données, en particulier celles liées à l’identification d’objet. · Outils et solutions pratiques. Dans cette partie, nous allons utiliser des outils, et montrer comment ils peuvent être utilisés pour améliorer la qualité de données.

Compétences à acquérir :

Ce cours vise à présenter les problèmes liés à la qualité de données, et de présenter les solutions qui peuvent être utilisées pour les résoudre.

- System, Languages and Paradigms for Big Data

System, Languages and Paradigms for Big Data

Ects : 3

Enseignant responsable :

DARIO COLAZZOVolume horaire : 24

Description du contenu de l'enseignement :

Le cours s’articule en trois parties.

Dans la première, l’accent est sur le paradigme MapReduce et le système Hadoop, avec un focus sur son système de fichiers HDFS. Le cours illustrera les mécanismes de base de Hadoop pour le support de l'exécution parallèle de ‘dataflow’ MapReduce sur des clusters de machines. Une attention particulière sera donnée aux aspects algorithmiques et d’optimisation de dataflow MapReduce.

La deuxième partie présentera des langages de requête et d’analyse de données caractérisés par des mécanismes de haut niveau et qui sont compilé sur MapReduce. Le focus sera sur les langages Pig Latin et Hive, des langages incluant des mécanismes à la SQL. Les techniques de compilation vers MapReduce seront présentées.

La troisième partie sera consacrée à des évolutions de Hadoop, et en particulier au système Spark et au langage de support Scala. Le focus sera sur l’architecture de Spark, la notion de RDD, l'évaluation lazy de transformations et actions sur des collections distribuées RDD. Les notions apprises seront mises en pratique dans un projet où les étudiants devront concevoir un dataflow pour l’analyse de grands volumes de données. L'implémentation sera faite tant en MapReduce qu’en Spark, et une analyse expérimentale sera effectuée pour comparer les performances des deux implémentations.

Compétences à acquérir :

Apprentissage des aspects fondamentaux des technologies Big Data pour la gestion et analyse de données massives.

- Visualisation de données

Visualisation de données

Ects : 3

Enseignant responsable :

TARIQ NEKROUFVolume horaire : 24

Description du contenu de l'enseignement :

Représenter des données de manière visuelle permet de tirer parti des capacités humaines en termes de perception et de cognition pour identifier des motifs particuliers, des éléments singuliers ou encore des anomalies dans ces données. La visualisation permet aux utilisateurs de systèmes d'information d'explorer leurs données de manière interactive, d'en avoir une vue d'ensemble, d'en extraire de l'information qui pourrait difficilement être obtenue à travers des processus d'analyse automatique (fouille, apprentissage), de formuler de nouvelles hypothèses qui pourront ensuite être vérifiées, par exemple, au moyen de tests statistiques. Au-delà de ces aspects exploratoires, la visualisation de données sert aussi d'aide à la prise de décisions, et de support à la communication entre individus des résultats d'analyses effectuées sur ces données. Le but de ce cours est de donner une vision d'ensemble du domaine, des principes fondamentaux de la perception visuelle humaine aux techniques de visualisation adaptées aux différentes structures de données (données multivariées, arbres, graphes, séries temporelles, etc.). Les travaux pratiques seront réalisés au moyen de la bibliothèque D3 (Data-Driven Documents).

Compétences à acquérir :

- Vue d'ensemble du domaine de la visualisation de données - Perception visuelle - Visualisation de données multivariées - Visualisation de structures arborescentes - Visualisation de graphes et réseaux - Visualisation de données temporelles - Visualisation multi-échelle - Systèmes et boîtes à outils pour la visualisation

- Web des données

Web des données

Ects : 3

Enseignant responsable :

MARIE-JOSE BELLOSTAVolume horaire : 24

Description du contenu de l'enseignement :

Langage dédié à la transformation de données XML (XSLT). Ce langage est utilisé par les WEBMASTER pour l’automatisation de la production des sites WEB et par les développeurs pour la création et la mise à jour automatique de tout document. L’accent est mis sur les concepts XSLT pour la visualisation des documents et des images. Langage permettant de garantir la conformité de documents en fonction d’une définition de type de documents (Langage XML schema). Ce langage peut être utilise pour créer des documents XML pour une large variété d’applications telles que la syndication, les échanges de documents et le stockage de données dans un format standard. Cet apprentissage permettra l’étude d’un schéma XML sur les documents juridique (legifrance) WEB sémantique en quatre parties : le processus de développement d’une ontologie, les Langages permettant la définition d’ontologies RDF, OWL 2, et l’interrogation de documents à partir d’une ontologie SPARQL, et le développement collaboratif d’une ontologie. Cet apprentissage permettra de traiter de manière détaillée des exemples de descriptions ontologiques existantes comme l'ontologie ELI qui fournit un cadre de description pour structurer les métadonnées des ressources législatives nationales et européennes, et les publier sur le web de données ou l’ontologie. De manière applicative, il commence par l’exploration, sous le logiciel Protégé 5.2 de l’université de Sandford, d’une ontologie existante, puis par la modélisation et définition d’une ontologie de domaine sous le logiciel Protégé. Contrôle de connaissance : se décompose en deux parties, la première est un contrôle continu comprenant des TD notés, et la deuxième est un projet où les étudiants en groupe de 2 ou 3 font un exposé sur des Applications ou nouvelles technologies autour du WEB.

Compétences à acquérir :

Former les étudiants aux standards du Web de données et du Web sémantique. Dans le contexte du web sémantique, les ontologies jouent un rôle prépondérant dans la spécification des connaissances de manière standard afin de permettre l’interopérabilité entre différents systèmes. Une ontologie correspond à un vocabulaire contrôlé et organisé et à la formalisation explicite des relations créées entre les différents termes du vocabulaire. Elle permet de préciser formellement un vocabulaire commun dans une perspective de partage. Les ontologies informatiques permettent de représenter un corpus de connaissances sous une forme utilisable par une machine. Ainsi, une ontologie avec un ensemble de règles constitue une base de connaissance permettant de développer un système d’aide à la décision.

Bibliographie-lectures recommandées

Référence(s) : Semantic Web Programming, John Hebeler, Matthew Fisher, Ryan Blace, Andrew Perez-Lopez, Édition : O'Reilly - 304 pages , 1re édition, 1er juillet 2009 Semantic Web for the Working Ontologist, Second Edition: Effective Modeling in RDFS and OWL 2nd Edition, Dean Allemang (Author), James Hendler (Author) 2011. XSLT 2.0 and XPATH 2.0, programmer’s reference, Mickael Kay, 4ième édition, Wiley Publishin Inc., 2008, XML Schema, The W3C's Object-Oriented Descriptions for XML, Eric van der Vlist, Publisher O'Reilly Media, 2002 .

UE Obligatoires

- Anglais

Anglais

Ects : 3

Enseignant responsable :

VERONIQUE BOURRELVolume horaire : 36

Description du contenu de l'enseignement :

Contenu : professionnel, culturel, d’actualité et de société

Forme : débats, jeux de rôles, quiz et activités ludiques

Méthodologie : prise de parole en public, travail sur l’expression orale

Pré-requis recommandés :

Une volonté de s’investir et un niveau d’anglais correct

Pré-requis obligatoire :

Une attitude professionnelle (ponctualité et sérieux)

Compétences à acquérir :

Savoir s’exprimer à l’oral

Améliorer ses compétences langagières et communicationnelles

Enrichir son vocabulaire

Développer sa créativité

Travailler en équipe

Mode de contrôle des connaissances :

100% contrôle continu

5 notes : jeu de rôles S1 + oral S1 + présentation orale S2 + jeu de rôles S2 + note d’oral S2

- Apprentissages Automatiques appliqués

Apprentissages Automatiques appliqués

Ects : 4

Enseignant responsable :

KEVIN VUVolume horaire : 36

Description du contenu de l'enseignement :

- Introduction - Objectifs et panorama du datamining et du Machine learning - Méthodes non supervisées : Réduction de dimensionnalité Clustering : K-means, CAH Approches probabilistes : EA Approches spectrales Application à une segmentation marketing Application au Text Mining Règles d’association -Méthodes supervisées : Régression logistique Arbre de Décision Méthodes à Noyaux Approches neuronales Application au scoring

Compétences à acquérir :

Il s'agit d'initier les étudiants à l’apprentissage automatique (machine learning) et à la pratique de la fouille (data mining) et l’extraction de connaissances à partir des grandes masses de données. Il sera illustré par des cas concrets des exemples réalisés en session avec le logiciel R. L’évaluation se fait par examen et par un challenge Kaggle (kaggle.com)

- Données et Ethique

Données et Ethique

Ects : 2

Enseignant responsable :

OLIVIA TAMBOUVolume horaire : 18

Description du contenu de l'enseignement :

Introduction : - Qu’est-ce que l’éthique (distinction, articulation entre éthique, droit, morale). - De quelles données parle-t-on ? - Pourquoi une éthique des données aujourd’hui ? Les principaux enjeux : le développement de l’Intelligence artificielle et la question du respect de dignité humaine, dépersonnalisation, déresponsabilisation, encadrement nécessaire de la gouvernance algorithmique (Cambridge Analytica) Partie 1 : Les différentes formes d’encadrement de l’éthique des données - L’encadrement collectif Des obligations actuelles fixées par les Etats et l’UE (RGDP) Des tentatives de régulation à l’échelle internationale Une forme de responsabilité sociétale des entreprises (développement de code de conduite, d’outils de privacy by design ou by default) - Une responsabilité individuelle : Du cas de conscience à la revendication du statut de lanceur d’alerte Partie 2 : L’émergence de principes éthiques des données - Les initiatives en cours : Les recommandations de la CNIL : Vers la concrétisation d’un principe de loyauté des algorithmes et d’un principe de précaution en matière d’Intelligence Artificielle ? Le projet de lignes directrices en matière d’éthique dans le domaine de l’IA développée par la Commission européenne Vers une charte constitutionnelle française du numérique ? - Les questionnements éthiques spécifiques : La revendication d’un droit des robots Vers la création de biens communs numériques ? - Les bonnes pratiques sectorielles : Ethique des données dans le domaine de la finance, de l’éducation, de la santé etc.

Compétences à acquérir :

La profonde transformation numérique de nos sociétés rend nécessaire comme l’a encore récemment rappelé la CNIL de « former à l’éthique tous les maillons de la chaîne algorithmique, concepteurs, professionnels, citoyens ». La création de ce nouveau cours Données et Ethique s’inscrit dans cette optique. Il s’agit de permettre aux informaticiens de prendre conscience des implications éthiques et sociales du traitement des données qu’ils opèrent. Il s’agit aussi les informer sur l’évolution du cadre dans lesquels ils vont pouvoir ou devoir mettre en œuvre le traitement de leurs données tant à titre personnel que professionnel. L’éthique est une notion souvent difficile à cerner. Elle repose sur un ensemble de règles morales susceptibles d’orienter le comportement des individus voire des entreprises. Ces règles qu’ils s’imposent à eux-mêmes peuvent soit préfigurer, soit en réalité se superposer ou se confondre avec des règles juridiques contraignantes. Ainsi, l’éthique des données se développe à titre collectif qu’à titre individuel notamment avec la figure des lanceurs d’alerte. En outre, l’éthique des données peut varier en fonction de la catégorie de données en cause (données personnelles, non personnelles, données dite d’intérêt général etc.). Ces prémisses sont importantes pour comprendre les enjeux économiques et sociétaux autour de l’émergence actuelle des principes éthiques des données.

- Data, Models and Decisions

Data, Models and Decisions

Ects : 3

Enseignant responsable :

HASSAN AISSIVolume horaire : 24

Description du contenu de l'enseignement :

Les problèmes rencontrés en pratique sont souvent complexes et mal définis à cause en partie des données incertaines ou imprécises. Les modèles et techniques mathématiques jouent un rôle important pour appréhender une réalité complexe et proposer de bonnes décisions. Le but de ce cours est de montrer comment utiliser les données afin de bâtir des modèles et améliorer les décisions. Des études de cas pratiques seront étudiées en utilisant le modeleur OPL de CPLEX ainsi qu’Excel.

1. Décision dans l’incertain : optimisation linéaire robuste et modèles de simulation. 2. Optimisation multi objectifs : concepts fondamentaux, méthodes d’énumération de l’ensemble des solutions efficaces. 3. Optimisation non-linéaire : formulation de problèmes par des modèles non-linéaires, analyse graphique, résolution informatique.

Compétences à acquérir :

Savoir comment utiliser les données afin de bâtir des modèles et améliorer les décisions.

Bibliographie-lectures recommandées

Référence(s) : Bertsimas, Dimitris, and Robert Freund. Data, Models, and Decisions: The Fundamentals of Management Science. Dynamic Ideas, 2004.

- Négociation

Négociation

Ects : 3

Enseignant responsable :

BRUNO GIRAUDON

PATRICK DELEMMEVolume horaire : 24

Description du contenu de l'enseignement :

L’objectif du cours est une initiation théorique et pratique à la négociation. La méthode du cours est de relier constamment les résultats des simulations auxquelles participent activement les étudiants avec les éléments fondamentaux de toutes négociations, objets d’acquisition du cours. Le séminaire est aussi rythmé par un ensemble de vidéos d'acteurs de la sphère publique et privée qui témoignent de leurs expériences et proposent des idées. Ces vidéos sont aussi des objets d'analyses et de débats. Le séminaire se termine par une grande négociation multilatérale qui permet la mise en pratique immédiate des théories et techniques vues, tout en permettant de prendre mieux conscience de ses forces et faiblesses individuelles en négociation. Un focus est proposé sur les conditions particulières d'une négociation de recrutement, notamment en ce qui concerne le droit du travail, les clauses d'un contrat et l'ensemble des informations nécessaires afin de renforcer sa capacité à négocier.

Compétences à acquérir :

Initiation théorique et pratique à la négociation.

- Modélisation Sécuritaire : Initiation aux Méthodes Formelles

Modélisation Sécuritaire : Initiation aux Méthodes Formelles

Ects : 3

Enseignant responsable :

FLORIAN JAMAINVolume horaire : 21

- Systèmes intelligents en aide à la décision

Systèmes intelligents en aide à la décision

Ects : 3

Enseignant responsable :

MARIE-JOSE BELLOSTAVolume horaire : 24

Description du contenu de l'enseignement :

Les problèmes de décision impliquant plusieurs intervenants font l’objet de nombreux travaux, aussi bien en informatique (systèmes d’aide à la décision collective, systèmes multi-agents, systèmes répartis, systèmes de diagnostic...) qu’en économie et en théorie de la décision (choix social, théorie des jeux...). Avec le développement d’applications réparties coopératives (nécessitant des mécanismes de décision collective, de vote ou de consensus) ou d’applications multi-utilisateurs pour le web (commerce électronique, partage de compétences...), le domaine de la décision collective est en plein essor. Aussi devient-il nécessaire de concevoir des systèmes efficaces de décision collective.

L’objectif du cours est l’étude de systèmes complexes de résolution de problèmes pour l'aide à la décision de groupe et plus précisément, l’étude de systèmes intelligents destinés à automatiser, à diagnostiquer ou à aider la prise de décision de groupe.

Le cours vise à présenter différents modèles, outils et méthodologie pour le développement de tels systèmes. Le fil rouge de ce cours s’appuie sur le concept d'agent intelligent, et se positionne assez largement dans le domaine de l'intelligence artificielle distribuée. Les agents intelligents peuvent présenter une certaine autonomie, ont des croyances et des préférences qui leur sont propres, ainsi que des capacités de raisonnement, de communication, et de prise de décision.

Contenu : Parmi les thèmes étudies, citons : - Diagnostic à base de modèles et diagnostic à base d’agents - Négociation entre agents, - Enchères électroniques et détermination du gagnant - Business Intelligence et intégration de données hétérogènes - Simulation des processus de décision collectifs

Les domaines d’applications privilégies sont : les systèmes d’aide à la décision dans le transport (transport intelligent), les systè mes d’aide à la décision dans la gestion de l’environnement : aide aux agriculteurs (gestion de parcelles), aide aux organisations territoriales (gestion de l’eau, gestion des crues des rivières), commerce électronique et négociation automatique, gestion automatique de l’énergie domestique (domotique).

Pré-requis obligatoire :

Programmation java

Compétences à acquérir :

programmation multi agents, protocoles FIPA, actes de langages FIPA, modèle décisionnel

Mode de contrôle des connaissances :

50%CC + 50% examen

Bibliographie-lectures recommandées

Bibliographie : Intelligent Agent-Based Business Intelligence, Samo Bobek , Igor Perko Entreprise Integration using the agent paradigm: foundations of multi-agent based integrative business information systems. Decision Support Systems (2006) by R.Kishore, H.Zhang, R.Ramesh

- Livret d'entreprise et apprentissage

Livret d'entreprise et apprentissage

Ects : 1

UE Obligatoires

- Mémoire

Mémoire

Ects : 9

Formation année universitaire 2024 - 2025 - sous réserve de modification

Modalités pédagogiques

La formation démarre en septembre, dont la présence en cours est obligatoire. Le rythme d'alternance du parcours MIAGE Informatique Décisionnelle en apprentissage est de : quatre semaines en entreprise / deux - trois semaines à l'université.

Les enseignements de la 2ème année de master mention Informatique parcours MIAGE Informatique Décisionnelle formation en apprentissage sont organisés en semestre 3 et semestre 4. Chaque semestre est constitué d'UE auxquelles s'ajoute un mémoire pour le semestre 4.

La note finale d'une UE est obtenue par pondération entre des notes de contrôle continu, de projets, d'examens partiels et terminaux. La note de contrôle continu peut faire intervenir plusieurs éléments : projet, devoirs, interrogations écrites ou orales, et note de participation.

Stages et projets tutorés

Le stage se déroule sur une durée de cinq à six mois. Le sujet du stage doit être validé par le responsable de la formation avant le début du stage. A l'issue du stage, l'étudiant dépose une version électronique du rapport et remet deux exemplaires papier du rapport signés par le tuteur entreprise au secrétariat de la formation. Le rapport doit-être remis au plus tard quinze jours avant la date de la soutenance définie par le secrétariat de la formation.

Des programmes nourris par la recherche

Les formations sont construites au contact des programmes de recherche de niveau international de Dauphine, qui leur assure exigence et innovation.

La recherche est organisée autour de 6 disciplines toutes centrées sur les sciences des organisations et de la décision.

En savoir plus sur la recherche à Dauphine